SD Bild Generierung. modula-r.com 2025/V01

Warum Interferenz Bildausdruck und Generation – oder: Warum Stable Diffusion nicht "perfect on demand" sein kann🛡️

Grundlagen: Wie Stable Diffusion Bilder erzeugt

Stable Diffusion (SD) generiert keine Bilder aus Vorlagen – es erzeugt Wahrscheinlichkeitsfelder aus Rauschen, die auf einen Zielausdruck „zuschwimmen“. Der Prozess beginnt mit rein gaußverteiltem Rauschen, das dann in mehreren Denoising-Schritten in Richtung einer Bildstruktur rekonstruiert wird.

Mathematisch:

xt = N(0,I) (reines Rauschen)Das Modell „lernt“, wie man diesen Rauschzustand wieder in Bilddaten x₀ zurückführt:

Die Bildentstehung ist daher kein direktes Zeichnen, sondern ein „konditioniertes Erraten“ – basierend auf Milliarden von Beispielen.

𝑝𝜃(𝑥0∣𝑥𝑡)=Verteilung der ursprünglichen Daten, gelernt durch Training.Die Bildentstehung ist daher kein direktes Zeichnen, sondern ein „konditioniertes Erraten“ – basierend auf Milliarden von Beispielen.

Gaußsche Unschärfe – im Herzen jedes Bildes

Im Training und der Generierung ist Gaußsches Rauschen (normalverteiltes Rauschen) zentral.

Es dient dazu, Bildinformation zu zerstören – und dadurch das Modell zu zwingen, zu „rekonstruieren“.

Das ist kein Bug, sondern das Lernprinzip.

Doch: Gaußverteilungen erzeugen immer Unschärfen im Detailbereich – v. a. dort, wo:

- zu viele semantische Varianten möglich sind (z. B. Hände, Text, Gesichter),

- oder der Prompt zu diffus ist,

- oder das Training nicht stark genug auf bestimmte Elemente konditioniert.

Semantik

≠ Klarheit: Warum der Hi-Res Fix nicht alles löstDer Hi-Res Fix (oder Latent Upscaling) verbessert die Auflösung, aber nicht die Semantik.

Er „schärft“ ein bereits erzeugtes Layout – aber wenn das Layout instabil war, verstärkt er auch die Fehler.

Stark vereinfachtes Prinzip:

- Erzeuge Bild in z. B. 768×768.

- Upscale z. B. auf 1024×1024.

- Re-diffuse (teilweise) mit Denoise z. B. 0.4–0.5.

- Gesichter, Hände, Schrift etc. bleiben erratene Felder.

- Der Fix ist kein intelligenter Korrektor, sondern eine weichgezeichnete Verstärkung.

Doch:

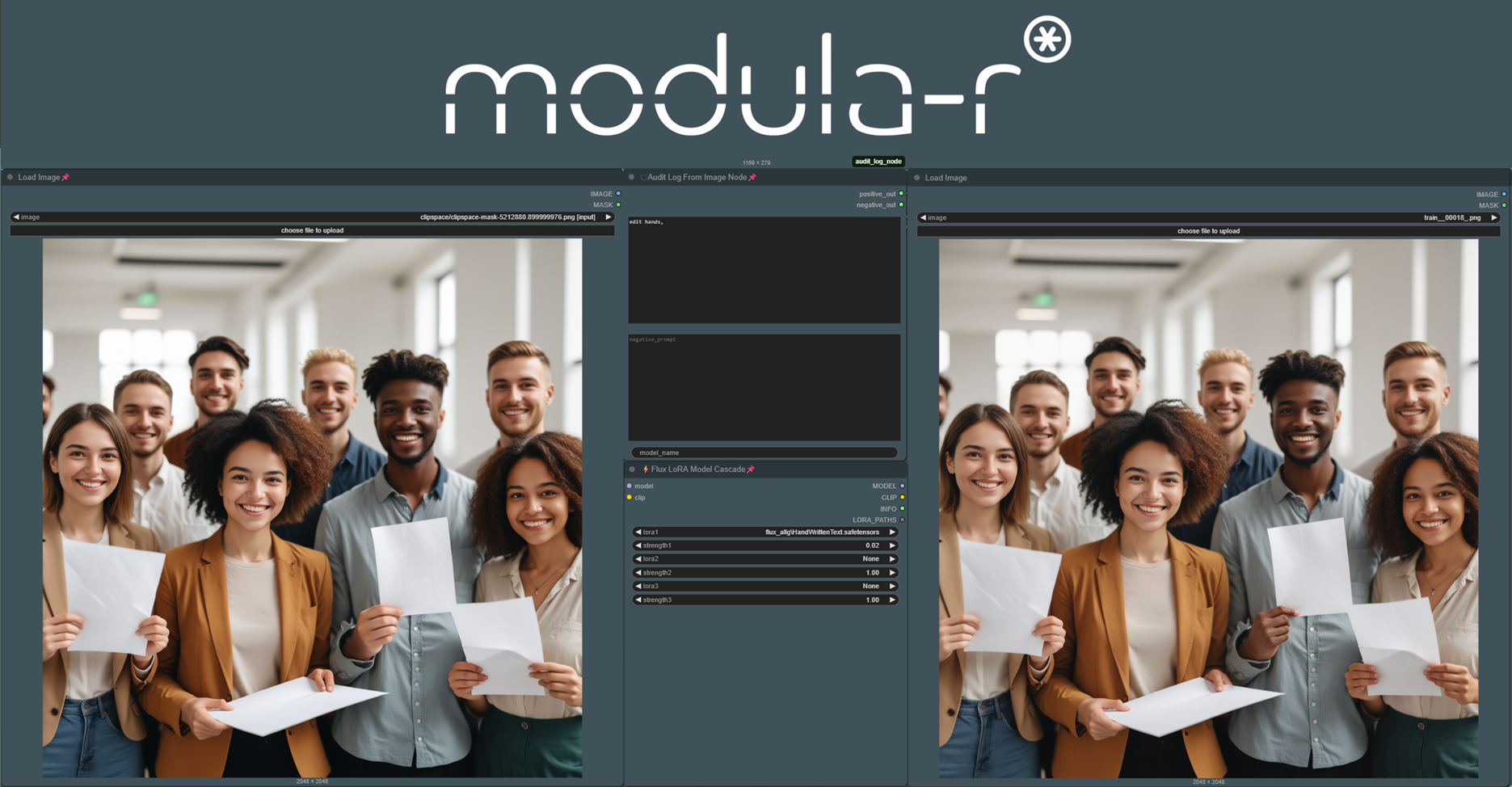

Raw-Image vs. entwickeltes Bild: Warum Inpainting Pflicht ist

Ein SD-Output ist wie ein analoges Negativ: ein belichtetes Rohbild.

Beispiele:

- | Zustand | Eigenschaft |

- | -------------- | ----------------------------------------------- |

- | Raw-Image | Ausdruck des Rauschfelds mit latenten Fehlern |

- | Inpainting | gezieltes Überschreiben einzelner Semantikzonen |

- | Prompt-Control | versuchsweise Steuerung über Token/Negative |

- | Final-Output | kuratiertes, korrigiertes Bild |

Ein professioneller Workflow nutzt SD wie ein Scanner mit Variablen, nicht wie eine Kamera mit Garantie.

Fazit: SD ist wahrscheinlich, nicht exakt

Stable Diffusion ist ein hochwirksames Wahrscheinlichkeitsmodell, das durch Gaußsche Prozesse Bilder entstehen lässt. Es kann atemberaubend realistisch wirken – aber es garantiert nichts.

Wer perfekte Hände, präzise Logos oder konsistente Charaktere braucht, muss verstehen:

- Promptarbeit ist Steuerung, kein Befehl.

- Training ist Einflussnahme, kein Fix.

- Inpainting ist Nachbearbeitung, keine Schwäche.

- Gesichter, Hände, Schrift etc. bleiben erratene Felder.

- Verstehen

≠Kontrolle – sondern Vertrauen in das Rauschen.

Vertrauen ist hier nicht romantisch. Es ist mathematisch.

„Stable Diffusion liefert nicht das perfekte Bild – sondern die beste Annäherung an eine Idee im Rauschen.“

Tags to use

#AIAct2024-ready #TrustedWorkflow #SafePrompting #ComfyAudit #DSGVOkonform #EasyStart #WhiteHatOnly #SecureCreative #ModularAI #FastLearnEnvironment #UniqueUX #KIBremenSource